蘋果最近真是「高產(chǎn)」!

這幾天,蘋果在多模態(tài) web 搜索中發(fā)現(xiàn)了賦能多模態(tài)大語言模型(MLLM)的新解法

在現(xiàn)實世界的應(yīng)用中,MLLM 需要訪問外部知識源,并對動態(tài)變化的現(xiàn)實世界信息進行實時響應(yīng),從而解決信息檢索和知識密集型的用戶查詢。當前的一些方法,比如檢索增強生成(RAG)、search agent 以及配備搜索功能的多模態(tài)大模型,往往存在流程僵化、搜索調(diào)用過多以及搜索查詢構(gòu)造不當?shù)葐栴},導致效率低下以及結(jié)果不理想。

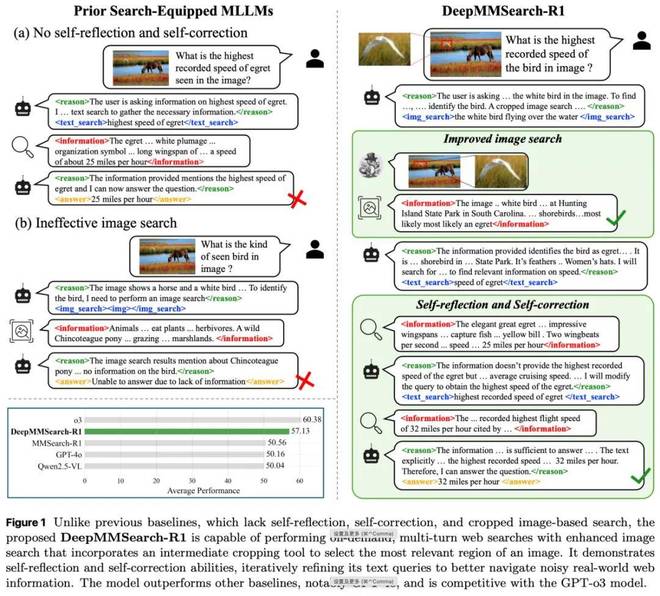

為了克服以往研究中暴露出的局限,蘋果提出了 DeepMMSearch-R1 模型。該模型能夠按需執(zhí)行多輪網(wǎng)絡(luò)搜索,并可針對文本與圖像搜索工具動態(tài)生成查詢,如圖 1(右)所示。具體而言,DeepMMSearch-R1 能夠通過自我反思與自我糾正,在多輪交互中自適應(yīng)地生成和優(yōu)化文本搜索查詢,并利用檢索到的內(nèi)容作為反饋以及結(jié)合原始問題進行改進。

為了提升圖像搜索的效果,蘋果引入一個中間圖像裁剪工具(Grounding DINO)來應(yīng)對背景噪聲和干擾性視覺實體帶來的挑戰(zhàn)。過程中,DeepMMSearch-R1 首先生成與問題最相關(guān)視覺實體的指代表達,然后利用該表達由裁剪工具動態(tài)識別并裁剪出圖像中對應(yīng)的區(qū)域。生成的裁剪圖像隨后被用于圖像搜索,以檢索與上下文更相關(guān)的結(jié)果。這種有針對性的搜索方式顯著提升了檢索質(zhì)量,并大幅提高了整體性能。

蘋果采用兩階段訓練流程:首先進行有監(jiān)督微調(diào)(SFT),然后通過 GRPO 算法進行在線強化學習(RL)。其目標是讓模型學會何時發(fā)起搜索、使用哪種工具、搜索什么內(nèi)容,以及如何基于檢索到的內(nèi)容進行推理,以決定下一步行動:是直接給出最終答案,還是進一步優(yōu)化查詢并發(fā)起新一輪搜索。

本文主要包括以下三個方面的貢獻:

一是提出新的數(shù)據(jù)集 DeepMMSearchVQA。該數(shù)據(jù)集包含多樣化多跳視覺問答樣本,并以多輪對話的形式呈現(xiàn)。它在不同知識類別之間保持平衡分布,涵蓋了既需要搜索又無需搜索的問題類型。

二是構(gòu)建真實世界的多模態(tài)搜索流程,并整合了三種工具:(1)文本搜索工具,使模型能夠發(fā)出有針對性的查詢,從而檢索相關(guān)網(wǎng)頁并獲取最新的事實性知識;(2)基于 Grounding DINO 的圖像定位工具,可根據(jù)模型生成的與問題視覺實體相關(guān)的指代表達,識別并裁剪輸入圖像中的相關(guān)區(qū)域;(3)圖像搜索工具,可基于輸入圖像(無論是裁剪圖還是完整圖)檢索網(wǎng)頁內(nèi)容,包括標題與描述,幫助模型通過網(wǎng)絡(luò)信息識別不熟悉的視覺實體。

三是通過兩階段訓練過程實現(xiàn)了 SOTA 性能,超越以往的開源基線模型(見圖 1)。該訓練過程包括使用 SFT 進行冷啟動初始化,隨后采用 GRPO 算法進行在線強化學習。